NVIDIA データセンター GPUとは?

NVIDIAデータセンターGPUとは、通常のコンピューターよりも大規模で高速なデータ処理を必要とする場所(=データセンター)で使われる、特別な「グラフィックス プロセッシング ユニット (GPU)」のことです。

GPUは本来、映像処理(グラフィックス)を高速に行うための装置ですが、いまではAI(人工知能)やディープラーニング(深層学習)などの高度な演算にも使われるようになりました。

データセンター向けGPUは、特に大規模で高度な解析や機械学習に対応できるよう、AIに特化したコアや大容量のVRAMが搭載されています。

NVIDIA データセンター GPU 製品でできること

AIや機械学習の高速化

AIを学習させたり、推論(結果を導く作業)するときの処理を大幅にスピードアップしてくれます。

ハイパフォーマンス コンピューティング(HPC)

AIを学習させたり、推論(結果を導く作業)するときの処理を大幅にスピードアップしてくれます。

大規模なデータ分析

ビッグデータを扱う企業や研究機関で、データを瞬時に分析し、結果をすばやく得ることができます。

主な特徴・技術

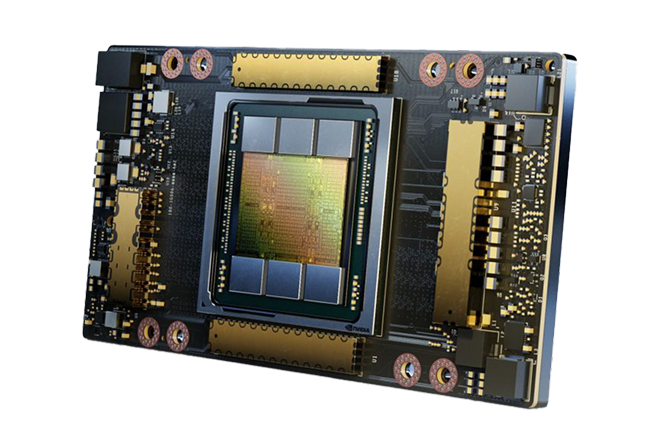

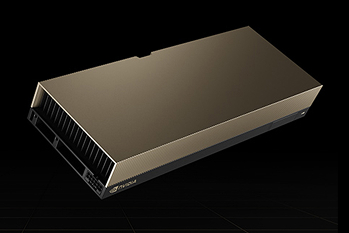

NVIDIA H100 Tensorコア

- 動的に演算を調整することで正確さを維持しながらスループットを加速

- 多数のAIおよびハイパフォーマンスコンピューティング (HPC) タスクを高速化

- トランスフォーマーネットワークトレーニングを6倍高速化

- すべてのアプリケーションで 3 倍のパフォーマンス向上

Multi-Instance GPU (MIG)

- GPUを完全に分離された複数の小さなインスタンスに分割

- メモリ、キャッシュ、コンピューティングコアを完全に分離

- 最大7個のGPUインスタンスで仮想環境のマルチテナント/マルチユーザー構成をサポート

- MIGインスタンスごとに専用のビデオ デコーダーが与えられ、共有インフラストラクチャで安定したハイスループットのインテリジェント ビデオ解析 (IVA) が実現

Transformer Engine

- Transformer Engineは、近年のAI研究で主流になっている「トランスフォーマーモデル(文章や画像などの処理に強い仕組み)」をさらに高速化するための技術です。

- 数値の精度(FP8, FP16 など)をうまく組み合わせて計算することで、AIモデルの学習を格段にスピードアップします。

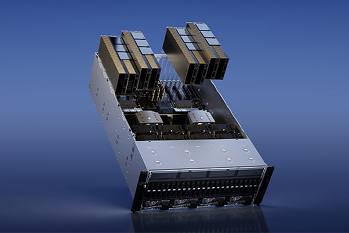

NVLink と NVLink Switch システム

- スケールアップに相互接続が可能

- NVLink Switchと組み合わせると、NVLink SwitchシステムはPCIe Gen5の7倍以上の帯域幅でGPUあたり900ギガバイト(GB/s)の双方向で複数サーバーにわたりマルチGPU IOを拡張可能

- 最大256基のH100を接続したクラスターをサポート(前世代のAmpereと比較して約9倍の性能向上)

NVIDIA データセンターGPU製品ご紹介動画

混合精度コンピューティングにより必要に応じて計算の「正確さ」と「速さ」を切り替え、AIやHPCの大規模処理を今まで以上に高速化し、トランスフォーマーネットワークのトレーニングでは従来比6倍の速度、あらゆるアプリケーションでは3倍の性能向上を実現するなど、幅広い分野でのスピードアップが期待できます。

NVIDIA データセンターGPU製品の特長

01

NVIDIA H100 Tensor コア

混合精度コンピューティングにより必要に応じて計算の「正確さ」と「速さ」を切り替え、AIやHPCの大規模処理を今まで以上に高速化し、トランスフォーマーネットワークのトレーニングでは従来比6倍の速度、あらゆるアプリケーションでは3倍の性能向上を実現するなど、幅広い分野でのスピードアップが期待できます。

02

Multi-Instance GPU (MIG)

1つのGPUを複数に分割して完全に独立したメモリと処理回路を割り当てられる機能で、複数のユーザーや仮想マシンが安全かつ効率的にGPUを共有できるようになり、Hopperアーキテクチャでは最大7つのインスタンスに対応してコンフィデンシャルコンピューティングや専用ビデオデコーダーを備え、共有インフラ環境で安定したハイスループットの動画解析や同時実行MIGプロファイリングによる最適なリソース割り当てが可能です。

03

Transformer Engine

NVIDIA Hopperアーキテクチャと組み合わせてAIモデル(特にTransformer型)のトレーニングを劇的に高速化し、FP8やFP16など多様な精度を効率的に使い分けることで余分な処理を削減し、前世代と比べてTF32、FP64、FP16、INT8などの演算を最大3倍早く行い、第4世代NVIDIA® NVLink®との連携によってHPCやAIのワークロードを飛躍的に加速します。

04

NVLink Switch システム

第4世代NVLinkと新しい外部NVLink Switchを組み合わせることで、PCIe Gen5の7倍以上の帯域幅となるGPUあたり900GB/秒の双方向通信を複数サーバーにわたって拡張でき、最大256基のH100を接続するクラスターを構築し、Ampere世代のInfiniBand HDRより9倍高い帯域幅を実現するだけでなく、SHARP(In-network Computing)との組み合わせにより57.6TB/秒のAll-to-All通信や1exaflops規模のFP8スパースAIコンピューティングも可能にします。

NVIDIA データセンターGPU製品スペック一覧

H200

NVIDIA H200 Tensor コア GPUは、革新的なパフォーマンスとメモリ機能を備え、生成AIおよびHPCワークロードを強化します。HBM3eを搭載した初のGPUであるH200は、大容量かつ高速なメモリを提供し、科学コンピューティングによるHPCワークロードの推進と、生成AIや大規模言語モデル(LLM)の高速化を実現します。

| H200 SXM | H200 NVL | |

|---|---|---|

| FP64 | 34 TFLOPS | 30 TFLOPS |

| FP64 Tensor Core | 67 TFLOPS | 60 TFLOPS |

| FP32 | 67 TFLOPS | 60 TFLOPS |

| TF32 Tensor Core | 989 TFLOPS | 835 TFLOPS |

| BFLOAT16 Tensor Core2 | 1,979 TFLOPS | 1,671 TFLOPS |

| FP16 Tensor Core | 1,979 TFLOPS | 1,671 TFLOPS |

| FP8 Tensor Core | 3,958 TFLOPS | 3,341 TFLOPS |

| INT8 Tensor Core | 3,958 TFLOPS | 3,341 TFLOPS |

| GPU Memory | 141GB | 141GB |

| GPU Memory Bandwidth | 4.8TB/s | 4.8TB/s |

| Decoders | 7 NVDEC 7 JPEG | 7 NVDEC 7 JPEG |

| Confidential Computing | Supported | Supported |

| Max Thermal Design Power (TDP) | Up to 700W (configurable) | Up to 600W (configurable) |

| Multi-Instance GPUs | Up to 7 MIGs @18GB each | Up to 7 MIGs @16.5GB each |

| Form Factor | SXM | PCIe Dual-slot air-cooled |

| Interconnect | NVIDIA NVLink: 900GB/s PCIe Gen5: 128GB/s | 2- or 4-way NVIDIA NVLink bridge: 900GB/s per GPU PCIe Gen5: 128GB/s |

| Server Options | NVIDIA HGX™ H200 partner and NVIDIA-Certified Systems™ with 4 or 8 GPUs | NVIDIA MGX™ H200 NVL partner and NVIDIA-Certified Systems with up to 8 GPUs |

| NVIDIA AI Enterprise | Add-on | Included |

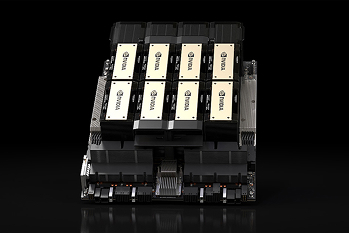

HGX H100

高性能かつ効率的なコンピューティングリソースを提供するプラットフォームで、内蔵のNVIDIA BlueField-3 DPUによってクラウドネットワーキングやセキュリティ、GPUコンピューティングの柔軟性が高まり、さらにMIG(Multi-Instance GPU)機能を利用することで、一台のH100を最大7つに分割して複数ユーザーが独立したGPUインスタンスを同時に使うことができます。

| NVIDIA HGX H100 4-GPU | NVIDIA HGX H100 8-GPU | |

|---|---|---|

| FP64 | 134 TFLOPS | 268 TFLOPS |

| FP64 Tensor Core | 268 TFLOPS | 535 TFLOPS |

| FP32 | 268 TFLOPS | 535 TFLOPS |

| TF32 Tensor Core | 3,958 TFLOPS* | 7,915 TFLOPS* |

| FP16 Tensor Core | 7,915 TFLOPS* | 15,830 TFLOPs* |

| FP8 Tensor Core | 15,830 TFLOPs* | 31,662 TOPS* |

| INT8 Tensor Core | 15,830 TFLOPs* | 31,662 TOPS* |

| GPU メモリ | 320GB | 640GB |

| メモリバンド幅 | 13TB/s | 27TB/s |

| NVLink | 対応 | 対応 |

H100 NVL

最大 700 億パラメーターの LLM (Llama 2 70B) の場合、NVLink ブリッジを持つ PCIe ベースの NVIDIA H100 NVL が、Transformer Engine、NVLink、188GB HBM3 メモリを利用して、あらゆるデータ センターで最適なパフォーマンスと簡便な拡張性を提供し、LLM を主流へと導きます。H100 NVL GPU を搭載したサーバーであれば、電力に制限のあるデータ センター環境で低遅延性を維持しながら、Llama 2 70B のパフォーマンスを NVIDIA A100 システムの最大 5 倍にまで向上します。

| NVIDIA H100 NVL [PCIe] | |||

|---|---|---|---|

| FP64 | 30 TFLOPS | FP64 Tensor Core | 60 TFLOPS |

| FP32 | 6 TFLOPS | TF32 Tensor Core | 835 TFLOPS |

| BFLOAT16 Tensor Core | 1,671 TFLOPS | FP16 Tensor Core | 1,671 TFLOPS |

| FP8 Tensor Core | 3,341 TFLOPS | INT8 Tensor Core | 3,341 TFLOPS |

| GPU メモリ | 94GB | メモリバンド幅 | 3.9TB/s |

| NVLink | 対応 | ||

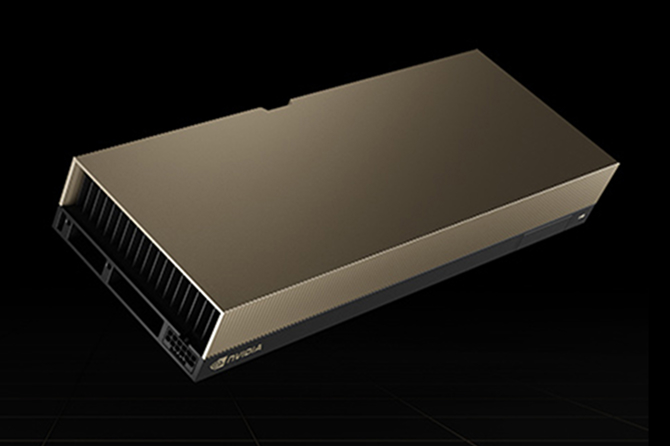

H100

これまでにない性能と拡張性、そしてセキュリティを備え、あらゆるワークロードに対応する高性能GPUです。NVIDIA® NVLink® Switch Systemを使えば最大256台のH100を接続してエクサスケール規模の処理を高速化でき、さらに専用のTransformer Engineによって、兆単位のパラメーターを持つ言語モデルを構築しながら前世代比30倍の高速化を実現します。

| NVIDIA H100 Tensor Core GPU[PCIe] | |||

|---|---|---|---|

| GPUアーキテクチャ | Hopper | GPUメモリ | 80 GB HBM2e |

| ECC機能 | 対応 | メモリバンド幅 | 2 TB/s |

| メモリバス | 5,120 bit | Compute Capability | 9 |

| CUDAコア | 14,592 | RTコア | 0 |

| Tensorコア | 456 | NVLink | 対応 |

| ベースクロック | 1,065 MHz | GPU Boost クロック | 1,620 MHz |

| 最大消費電力 | 350 W | 補助電源 | PCIe CEM5 16 pin |

| バスインターフェース | PCIe 5.0 × 16 | トランジスタ数 | 80 |

| マルチインスタンスGPU | 各10GBで最大7つのMIGS | 相互接続 | NVLink:600GB/sPCIe Gen5:128GB/s |

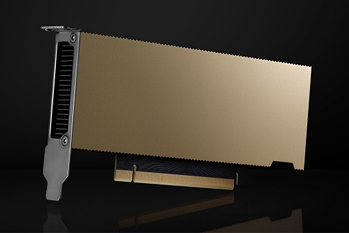

L40S

強力なAIコンピューティングと業界トップクラスのグラフィックス性能を兼ね備え、AIとグラフィックス両方の分野で突出したパフォーマンスを発揮し、さまざまなワークロードを効率的かつ持続的に高速化します。

| NVIDIA L40S | |||

|---|---|---|---|

| GPUアーキテクチャ | NVIDIA Ada Lovelace | GPUメモリ | 48 GB GDDR6 |

| メモリバンド幅 | 864 GB/s | CUDAコア | 8,176 |

| Tensorコア | Tensorコア | RTコア | 142 |

| NVLink | 非対応 | 冷却方式 | パッシブ |

| MIGサポート | なし | 補助電源コネクタ | PCI Express CEM5 16pin電源コネクタ×1 |

| 最大消費電力 | 350 W | サイズ | 高さ 111.15 mm 長さ 267.70 mm 2スロットサイズ(* ブラケット含まず) |

| 保証期間 | 3年間 センドバック方式 | ||

L40

Ada Lovelaceアーキテクチャを採用し、データセンター向けに他に類を見ないビジュアルコンピューティング性能を実現するだけでなく、Root of Trust によるセキュアブート機能を備え、データセンターのセキュリティを一段と強化します。

| NVIDIA L40 [PCIe] | |||

|---|---|---|---|

| GPUアーキテクチャ | Ada Lovelace | GPUメモリ | 48 GB GDDR6 |

| ECC機能 | 対応 | メモリバンド幅 | 864 GB/s |

| メモリバス | 384 bit | Compute Capability | 8.9 |

| CUDAコア | 18,176 | RTコア | 142 |

| Tensorコア | 568 | NVLink | 非対応 |

| ベースクロック | 735 MHz | GPU Boost クロック | 2,490 MHz |

| 最大消費電力 | 300 W | 補助電源 | PCIe CEM5 16 pin |

| バスインターフェース | PCIe 4.0 × 16 | トランジスタ数 | 76.3 |

| マルチインスタンスGPU | 非対応 | ||

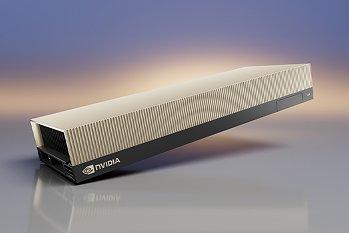

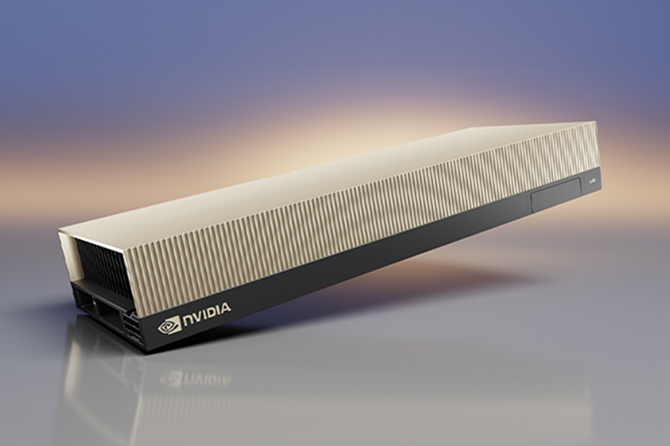

L4

NVIDIA L4 Tensor Core GPUは、NVIDIA Ada Lovelaceアーキテクチャを採用しており、ビデオ、グラフィックス、AI、仮想化、ビジュアルコンピューティングなどの分野で、最高水準の性能、耐久性を実現します。

| NVIDIA L4 [PCIe] | |||

|---|---|---|---|

| GPUアーキテクチャ | NVIDIA Ada Lovelace | GPUメモリ | 24GB GDDR6 |

| ECC機能 | 対応 | メモリバンド幅 | 300 GB/s |

| メモリバス | 192 bit | CUDAコア | 7,424 |

| RTコア | 58(第3世代) | Tensorコア | 232(第4世代) |

| NVLink | 非対応 | 最大消費電力 | 72W |

| 補助電源 | 不要 | ||

RTX A6000 Ada

NVIDIA RTX™ 6000 Ada 世代 は、今日の AI 活用ワークフローの課題に対応するための特徴、機能、パフォーマンスを提供します。NVIDIA Ada Lovelace GPU アーキテクチャを基盤に構築された RTX 6000 は、第 3 世代 RT コア、第 4 世代 Tensor コア、次世代 CUDA® コアと 48GB のグラフィックス メモリーを搭載しており、これまでにないレンダリング、AI、グラフィックス、およびコンピューティング パフォーマンスを実現します。NVIDIA RTX 6000 を搭載したワークステーションは、今日の極めて厳しいビジネス環境で成功するために必要なすべてを提供します。

| RTX A6000 Ada | |||

|---|---|---|---|

| GPU メモリ | 48 GB | ディスプレイ ポート | 4 基のDisplayPort |

| 最大消費電力 | 300 W | グラフィックス バス | PCIe Gen 4 x 16 |

| フォーム ファクター | デュアルスロット | サーマル | アクティブ |

| AI ソフトウェア サポート | NVIDIA AI Enterprise | vGPU ソフトウェア サポート | NVIDIA vPC/vApp、NVIDIA RTX 仮想ワークステーション |

NVIDIA製GPU搭載のAIインフラソリューションはこちら

パートナー